目的

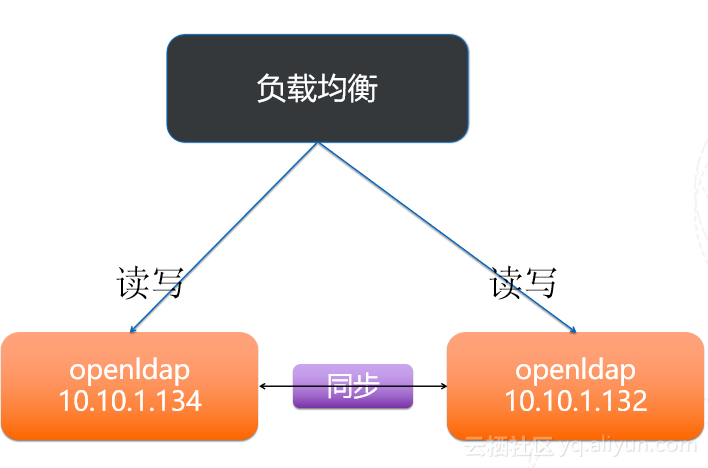

在实际产线运维环境下,可能包含多个IDC机房,每个机房的主机都需要通过OpenLDAP体系管理运维账户登录。这种情况下可以配置OpenLDAP的主从架构实现(当然同一个机房也可以配置主从架构,客户端配置ldap uri指定多个地址)。主openldap节点称为“provider”可读可写,从openldap节点称为“consumer”只读。

环境

| 主机名称 | 地址 | 版本 | 角色 | 备注 |

|---|---|---|---|---|

| sysldap-shylf-1 | 10.116.72.11 | CentOS7.6 min | openLdap, httpd, phpldapadmin | 主节点 |

| sysldap-shylf-2 | 10.116.72.12 | CentOS7.6 min | openLdap | 从节点,可以配置多从的 |

| systerm-shylf-1 | 10.116.72.15 | CentOS7.6 min | openLdap client |

前提条件,为了方便配置防火墙以及禁用selinux

配置示例:dc=example,dc=com